如何用AI说服游戏公司的甲方?

2023年年初,油管博主Corridor上传了一支名叫《石头剪刀布》的7分钟小短片,AI转绘给这支由真人实拍的视频带来了极具冲击力的视觉效果,让本平平无奇的猜拳游戏摇身一变成命运对决,斩获超400万播放量,被搬运到B站后也得到了超两百万次观看。

在商用领域,可口可乐的AI广告让名画动了起来,也不乏有AI全流程流浪地球宣传片、游戏PV等方面的实践尝试,在《石头剪刀布》发布大半年后的今天,我们邀请了实验电影导演海辛、腾讯光子工作室动效设计师林海峰,一起探讨AI图像能更好地动起来了吗?

海辛:

实验电影导演,AI 创作者,第25届上海国际电影节评委、猫眼签约动画制作人、多所艺术高校电影及 AI 方向的外聘讲师、为多家行业头部游戏公司及博物馆提供设计及咨询服务;

林海峰:

腾讯光子工作室动效设计师,LitGate 社区入驻达人。

成志ROSA:

主持人,AI+游戏市场观察者,GameTrigger投资副总裁

他们探讨的话题包括但不限于:

AI视频生成的工作流探索;

在游戏制作管线中如何应用AI视频生成?

最新的AI视频生成技术趋势;

如何看待AI视频生成可控性低的问题?

01 海辛分享:AI视频生成的工作流 01 个人短片制作流程之所以想到用AI做变换,是因为我觉得本质上Video2Video和做动画的逻辑是一样的,都是从(动态)分镜出发,中间通过渲染、做材质等流程,最后到成片,这也是未来AI发展比较有可行性的方向。当初做的时候还没有AnimateDiff,主要是用SD的流程,加上EbSynth维持关键帧的稳定性做出的效果。

这个视频的整个流程就是真人拍摄后,用SD来渲染关键帧,之后再放到EbySynth对镜头里面其他关键帧进行延续,使得它的画风大致保持一样,且减少画面的抖动。在第一个镜头可以看到它整体色彩有个大幅度的变化,这里就是用SD针对几个关键帧进行渲染,使得它的色彩变化非常明显,在后期剪辑时把它们衔接在一起。这种色彩的变化配合较大的人物动作弧线,能起到不错的效果。

第二个镜头我只做了一个关键帧,因为它动作很小,只是提供一个节奏点,所以这个画面的逻辑是不要运动,更多是吸引人的注意力。因此在EbySynth算了以后,它就会是很稳定的画风,不会有AI非常抖动的感觉。

第三个镜头是一个非常快速的运动镜头,我的处理方式是进行分层,前后景进行分别操作。前景人物还是只用一个关键帧来达到比较稳定的效果,后景背景我是直接用AI来算的每一帧,因为AI本身抖动的原因,再加上前景人物非常的固定,反而加强了它的运动模糊感和对人物的聚焦。

最后是做了一个变脸的效果,先用SD做in-painting,然后抠出来处理好一个关键帧,再把关键帧用EbySynth算出每个镜头,最后在这些组镜头里面作为素材进行剪辑,就可以做出比较丝滑的换脸效果。

分享整个小片子的制作其实想讲的是:AI动画没有一个非常固定的approach,它有很多的实现方向,但每个镜头的方式完全根据你的需求和创意决定。

02 AnimateDiff分享最近出的AnimateDiff的一个特点就是它可以保证帧与帧之间的相对丝滑,而还在前几个月。如果想要AI镜头达到丝滑的效果,具体的方式仍是用EbySynth算关键帧,或者像《石头剪刀布》用达芬奇的不断Deflerk的方式让它维持稳定。

而AnimateDiff的算法可以保证Vedio2Vedio时,在重绘幅度非常大的情况下,每一帧之间是相对稳定的。

这是我用线稿动画转成一个带材质动画的测试,虽然效果还一般,但是已经可以看出来,如果搭配足够好的SD模型,把节点式的地方设置好,这种风景动画是可以出到比较好的效果的。

这是我前两天做的另外一个测试,这个角色Lora是周启洛,我在想以后做这些动画片是不是都可以让一个角色来演另外一个角色,我做完这个动作,我用AI就可以转成这个人在做其他动作,虽然现在看起来还是有一点抖,但面部已经是比较丝滑了。

我们觉得AnimateDiff是一个非常好的解决方案,可能会对行业会有很大影响,之前AI动画的局限性就是太抖动,已经基本上能解决了,所以可以期待今年Animation会有大进展。

我感觉目前的AI工具已经可以成为AE里的一个子板块了,提供不同的效果,每种效果可服务于创作者本身需要调用的情况。我非常鼓励身边的人多了解AI,它还是非常有潜力的,即使不能快速替代已有的工作流,但仍可以把它当成一个特效滤镜来玩。

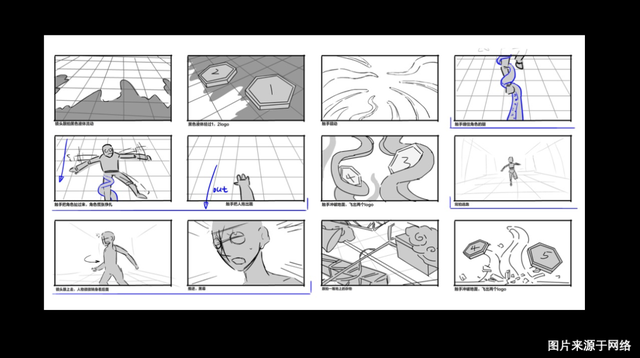

03 工作流分享1.第一步主要是先拍摄参考影片、制作动态分镜。

2.第二步在AI的部分,我现在用节点式的SD会多一些。因为它给的空间会大一些,对SD的运用也会多很多,再加上不同种类的ControlNet模型和AnimateDiff模型,可能会比之前SD单纯用workby的那一套要复杂很多,它需要你对于SD本身的各模块有更深刻的理解、对ComfyUI更熟悉(ComfyUI会比WebUI在跑动画上面要快很多),然后对ControlNet和AnimateDiff都要熟悉一些,虽然单独都不算复杂,但是把这些全部加一起的话,可能会存在一定的门槛,也使得它没有办法很快进行大规模的推广。

3.最后再到Post production环节,在一些常见的后期软件里进行。

我觉得整套Vedio2Vedio的门槛逐渐在往上走了,需要掌握的东西会比AI绘画多很多,但它有一个很好的地方就是它有新的节点型的工作流。我们经常会在一些社群里通过交换节点来复现一些效果;在项目中,对于同类型的镜头,我们就可以用节点型的工作流进行复用,不需要每次都精确的调整。

04 Claude2分享最后给大家分享一下我用GPT线的创作。我会把自己写的一些短篇小说整理好以后发给Claude2,它基本可以学习到我的风格并写出各种各样的故事。我有一个非常强烈的体会,就是AI会把创作者本身的特点放大,我自己在写小说的时候可能设定上非常有趣,但结局总是差强人意,在Claude2复现我的风格的时,也会遇到同样的感受。所以我觉得创作者需要对自己有非常深刻的了解,才能跟AI进行好的合作。

我特别喜欢第三个故事,原因是它的特点很明显,设定非常有趣,但它结局可能会稍弱

我在DallE3上也进行了一些探索,我想把故事做成绘本,让它设计分镜和Key frame,它可以和我讨论风格、最喜欢的部分、核心节奏点在哪等问题,我可以和AI去不断交流沟通。

具体该怎么画,它从第一章开始就会跟我一起创作,画的过程中出现错误也能通过对话来修改。我觉得在与AI交互过程中,它会帮助你在一些非常核心的工作流节点给你很多建议,比我以前自己创作要轻松多了。

05 QARosa:比如说现在我希望能够有一个买量素材的脚本创意,现在AI视频这一块能够辅助我去提炼整个的游戏卖点、思考买量视频的一些创意吗?

海辛:创意方面的话,很多人会推荐用GPT或者Claude2之类的进行辅助。我自己的体验是,如果直接去问,效果往往不太好,你需要给他足够多的参考,告诉他什么是好的,并且有足够好的Prompt。

Rosa:现在AI生成的视频能跟我需求的风格保持比较高的一致性吗?

海辛:如果你在调关键帧的阶段,就已经把风格调的非常切合,那基本就可以按照你想要的风格用其他工具来进行转绘。比如我调金克斯和蜘蛛侠的视频,都是确定想要什么样的画面后,再把其他帧给补上的。

对于一些比较有名气的IP像蜘蛛侠、金克斯会容易很多,因为模型本身就有大量已经训练的素材,再加上Lora训练会容易很多,然后如果是个人创作的IP会有难度,需要你训练一个更好的角色Lora或者是风格Lora来辅助。

Rosa:我尝试中发现视频生成会出现一个美少女可能会有三只脚的克苏鲁情况,这种情况已经被解决了吗?

海辛:你应该是文本生成视频吧,目前具体用到工作流里还比较少,原因是它直接生成素材的质量太不可控,哪怕质量好,你放到工作流里面又完全不知道它会生成怎么样的文本。因为文本和画面并不是一一对应的关系,如果没有ControlNet的加持基本就是一个灾难。所以如果想让它非常切题的完成你的想法,那逃不开ControlNet的使用,你要直接告诉它画面是怎样的。

Rosa:在AI视频里应该还挺需要选择一个合适的重绘幅度的,太低的话,画面可能不稳定,太高的话又和原画面的区别不大,怎么样去提高生成的稳定性呢?

海辛:现在有AnimateDiff已经基本解决问题了,可以保证在重绘幅度非常大的情况下,保证画面帧与帧之间依然有非常强的稳定性。AnimateDiff add value的地方其实就是它即使在重绘幅度非常高的情况下,每个帧之间依然是连续的,所以我们才会说它可以让ai动画更快的进入工作流。

Rosa:DallE3出来后有帮助解决当时困扰你们的一些什么问题吗,更多的应用在什么场景呢?

海辛:它是基于GPT的绘画大模型,它可以进行多模态的交互,你可以在它生成图片后跟它进行对话修改,它把对话与绘画模型集合在了一起,使得沟通时像跟AI同事一起工作一样。这是现在其他绘画工具还没有办法做到的,像SD、MJ都是单模态的,而DALLE3可以文本告诉它你想怎么修改。

目前其实还有蛮大的局限性,一是本身数据库的原因,使得整个模型的风格不够完备,另外就是它没有办法生成除了一比一像素以外的图像,但我们相信肯定是很快就可以被解决的问题。我觉得前者可能会麻烦一些,前者是各种风格没有办法被喂饱,现在大模型其实都还没有被喂饱。

Rosa:甲方一般会提出什么样的需求呢?DallE3出来后有帮助解决当时困扰你们的一些什么问题吗,更多的应用在什么场景呢?

海辛:目前我接到的一方面会有很多甲方在跃跃欲AI动画能到什么地步,看自己以前的工作流到底能被替换多少;另一方面是在短视频赛道,虽然在电影、长视频上还没有非常工业化,但短视频对于画面质量要求没有那么高,AI可以在短时间内以很低的成本,给画面带来很大的视觉刺激,在宣传推广上效果不错,现在ins和X上也有非常多短视频的创作者在研究该怎么做。

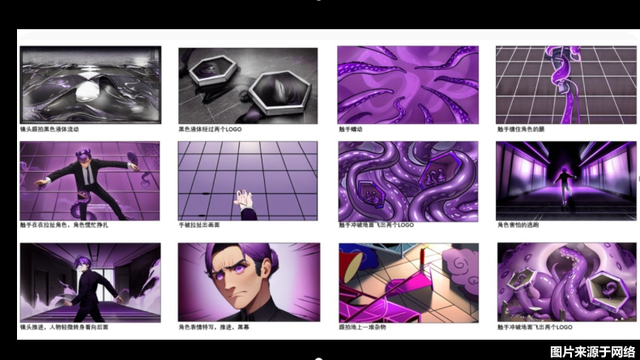

02 海峰分享:AI视频在游戏管线内该怎么用 01 实践探索我是一个游戏宅,平时喜做游戏攻略、研究心理学,现在是Knowyourself茶话会的主理人。这是今年3月份和两个小伙伴一起做的全AI流程视频,包括画面、Logo、配音、故事:

故事和MJ的提示词都是用ChatGPT生成的,MJ生出好图后,会在SD里面做一些重绘和放大的效果,最关键的是SD提供了一个深度插件;配音则是用微软的AI语音。当时AI出来后,我作为视频设计师,不需要原画协助就可以自己开始制作了,因此有了这个点子。

除了一些小效果是在AE内实现,其他都是基于AI做的,所有镜头只用了一天生成。

在游戏行业内,目前视觉品牌设计师用AI做物料已经非常成熟了,效率比以前提高很多,只需要画一下线稿,生成后再修一下图即可。项目中的角色也可以自己训练Lora,做初步动作设计的时候就不用找美术要了,甚至有些分镜都可以自己渲染。

像我这种动效设计师,我会手绘一些简单的简笔画分镜,再告诉AI你想要的东西,就能生成出来大家能看得懂的效果图了。在特效生成上,同样也是在有线稿以后,AI可以做到效果的生成,你画成序列帧也可以给到不同的效果,而不用像在以前每一帧火焰都去画。

02 工具探索我们也有关注Vedio2Vedio领域的应用,这是一个用Gen2做的流浪地球宣传片,在生成的700多张图片里选出来60多张。

你可以看到它动态表现其实很不错,但在内容上它跟流浪地球有时候也没有太多关联,这是因为它的出图还不太可控,没有办法调整一张图生成的动态,这也是Gen2比较大的缺点。而且目前Gen2没有二次元风格模型,大部分生成还是一种抽卡体验,镜头需要千挑万选。

接下来是AnimateDiff,最近一两个月它迎来了大升级,VR模式下可以根据一张图片来生成动画,这是基于SD的一个插件,而且可以用Control Net来控制输出,自由度是比较高的。目前真人模型还比较僵硬,但二次元模型的效果则好很多,SD里面有很多的模型可供选择,在这里也同样。

我们最近在研究墨化科技的“极影“插件,它将SD集成到了UE里,可以直接图像生成。此外还有一个更强的功能叫”贴图投射“,可以根据模型的外形结构生成贴合的高精度贴图,由UE实时渲染,甚至可以将光影、风格等后期工作实时修改。

这个功能本身没有什么技术壁垒,我了解到Blender其实也有这个功能,但是它接入AI后会有无限补图、拓展的功能,在贴图投射一些角度不太方便的情况下,AI能帮助把这些地方补上,且有很强的可控性。

以及另一个HDR的训练软件,只要你画出来相对的结构,它就会给你训练出一张全景贴图,贴图的类型本质上跟SD图生图的功能差不多,但它们更多的是集成到了软件内部。

关于未来,我觉得动补是非常值得期待的领域,现在的AI技术还不是很成熟,仍需要把人转换成骨骼,然后用模型再跟骨骼绑定,效率非常低,要用多部手机、长时间计算。

以后算力或是其他地方发展起来的话,或许能淘汰动补设备,进一步优化动画师的工作。我也看到一些Demo能够把人物抠出来,并行转换成其他设定的人物,它可以捕捉骨骼、表情、灯光合成。我觉得如果未来能够发展和普遍化的话,AI能够给整个工作流带来非常好的效果。

03 QA观众:Control Net和AnimateDiff的工作流可以去哪里学习呢?

海峰:推荐看哔哩哔哩智障君的视频,我尝试过,但目前还没有拿这个工作流做项目。

观众:极影可以进行3D模型的贴图吗?

海峰:可以的,它其实用的是3D投射,你只要把一张原画投上去以后,它就能做到推进的效果。只要你摄像机不要移动太大的角度,都是没有问题的,也可以看到3D的透视感。

成志:两位做视频的工作流里面,是先有音乐再有视频吗,在AI生成可控性低的情况下,根据音乐调整视频内容是否可行?

海辛:我认为AI更多是在做包装特效的工作,所以节奏很重要,需要先把整个节奏定下来。GQ的那条片子是先有音乐,我们大致先知道剪辑节奏、视频节奏是怎样的,然后根据音乐来确定大概会想要怎样的画面内容、镜头要多频繁、切得多快。给蜘蛛侠、安德玛、英雄联盟的视频就更是先有音乐了,AI在其中是作为特效加成。而不是主要部分,是在主体内容剪辑完后才加上的

海峰:我会看视频的需求,比如我用Gen2做,那可能是先定音乐,我做那个视频时把市面上的AI音乐软件全部试了一下,会需要比较多的音乐知识,然后我会根据生成的素材去剪,比如Gen2生成一个两秒视频,可能只是把中间的1.2s剪下来。如果我们做游戏的话,会有专门的音频同学,我们按照自己的节奏做好后再给他们去配音配乐,所以看你是需要哪种类型或者哪种流程。

Rosa:我发现两位在做视频时都是三个人一起完成,期间的分工是怎么样的呢?

海辛:我们在做GQ视频时另外两个人跟我掌握的技能点是完全一样的,所以我们基本可以cover对方的所有工作,效率也会更高。比如今天我做完初版等甲方反馈意见的时候,我可以再做其他事情,另外一个人接着我的项目工程继续即可。

海峰:我其实也差不多,在了解了市面上的AI工具后我感觉工作量是比较大的,我们是分镜头开展,比如我刚刚那个视频有12个镜头一人4个,期间我会负责生成故事、视频和音频的合成。

成志:在分镜生成中,AI目前能做到什么水平?

海峰:整个流程其实还是抽卡开盲盒,GPT其实我们也生成了超多的故事,你跟它沟通是有技巧的,不能只说我想要一个什么,而是要给很多条件限制,需要不断的磨合和尝试,你的条件越细致,生成结果可能也越细致。

成志:游戏公司作为甲方在合作中是否会有不一样的地方呢?

海辛:合作方式还是一样的,就是你给我参考影片、大概想要什么画风;跟以前不太一样的地方是大家其实并不完全清楚AI有哪些特效方面的东西、可以做出什么效果,所有我们现在会有个库,可以大概告诉你能做哪些效果,在这个上面给甲方一些参考。

成志:你们会觉得AI动画或视频领域未来或者现在研究的领域主要是什么,比如刚刚提到的稳定性?

海辛:我觉得AnimateDiff这一条线接下来会发展的特别快,以及相关的SD、Comfy UI节点式工作流可能会定义接下来AI动画到底该怎么走。它是一个可以复现的东西,在面对不同类型的镜头时,如果确定好了用某一方式工作,在具体的项目中就可以将镜头批量地进行AI转绘,这是非常有想象力的。在SD以后可能真的进入节点式的工作流,AnimateDiff是目前我看到最好的解决方案。

Rosa:AI产出视频时各位是如何面对版权争议问题的呢?

海辛:我们尽量不去用到可能会有版权争议的内容,无论大IP也好还是新内容,会标注好它是由AI生成的。以及甲方本身有版权的一些素材,尽量不使用公开的云平台把数据传上去,而是用本机来操作甲方的数据。

海峰:据我了解,你在充值Midjourney最高等级的账户时,它会说你生成的版权是归属于你个人的。但是其实我也有看到国外被起诉的案例,所以还是存在风险的。在游戏方面也是非常严格的,之前有一款游戏用了一些AI的模组,然后在steam就被下架了,甚至再也不能重新上架。

Rosa:在游戏生产中用到最多的地方是哪里,有哪些可能还只是停留在想象中,或者是因为尝试的成本实在太高了而不再去选择?

海峰:现在用的最多的是UI设计师做的图标,因为基本上是可控的,而游戏里很多的内容需要非常精确的东西,会有比较详细的要求,AI在这一方面还比较难做到,没有办法干预动态生成的过程。刚刚我分享的UE里的东西我们用的比较多一点,因为它是一种辅助,我们可以控制整个模型的结构,AI在这个基础上去生成贴图。

注:以上内容仅代表嘉宾个人观点,不形成任何普适性结论,其他讨论纪要将在后续逐步整理放出,敬请关注~